Die Zukunft hat schon begonnen -

Führen neue Dienstleistungsprodukte zu neuen Strategien für Bibliotheken?

Abstracts

1 Grenzen der lokalen Bibliothekssysteme

2 Der Markt kommt in Bewegung. Neue Konzepte, cloud computing und die Firmen

3 Chancen, Probleme und Fragen

4 Kurze Übersicht über Hersteller und Produkte

von Karl Wilhelm Neubauer

Die traditionellen lokalen Bibliothekssysteme leben schon lange. Sie werden sicher noch lange weiterleben. Inzwischen bringen aber einige Firmen Produkte auf den Markt, die die bisherige Arbeitsteilung in absehbarer Zeit grundlegend verändern könnten. Zumindest sind sie eine große Herausforderung für den bisherigen Betrieb von Bibliothekssystemen.

1 Grenzen der lokalen Bibliothekssysteme

Sie nennen sich Integrierte Bibliothekssysteme (ILS, Integrated Library System) und wurden ursprünglich nur für die Bearbeitung von gedruckten Dokumenten entwickelt. Die Integration bezog sich auf Geschäftsgang und Nutzung. Im Lauf der Jahre wurden dann Funktionen zu Bearbeitung und Recherche von elektronischen Dokumenten hinzugefügt. Es fällt aber schwer, bei den alten Systemen alle modernen Funktionen, die beim Einsatz elektronischer Dokumente anfallen, unterzubringen. Die Bedeutung der elektronischen Dokumente wuchs und wächst ständig. Vor allem die Zeitschriftenaufsätze wurden am einfachsten elektronisch zugänglich. Jetzt drängen die E-Books nach. Zur Integration gehören natürlich auch online Fachdatenbanken, Onlinekataloge usw.. Die größten Probleme verursacht die Integration der großen Welt des Internet mit einer schon fast unüberschaubaren Masse an Systemen und Daten.

Die Hersteller lokaler Bibliothekssysteme reagierten auf diese rasch wachsenden Anforderungen zunächst relativ hilflos. Sie versuchten sich durch Anstricken an die alten Systeme über die Runden zu mogeln. Sie waren Bibliotheken über Jahre hinweg nur eine schwache Stütze. Verleger und Zeitschriftenagenten entwickelten ihre Systeme für Zeitschriftenaufsätze, dann für E-Books. Seit Jahrzehnten gibt es die Hostingdienste für Onlinedatenbanken. Zwischen diesen und Volltexten gab es Verbindungen. Ansonsten dachten die Akteure nicht daran, zu kooperieren. Lediglich Elsevier startete Ende des letzten Jahrtausends einen Versuch und kaufte den Bibliothekssoftwarehersteller Endeavour. Inhalte und Bibliothekssoftware sollten zusammengehen. Inzwischen hat aber Elsevier Endeavour längst an Ex Libris, also wieder einen Bibliothekssoftwarehersteller, weiter verkauft. Elsevier selbst ging über Scopus den Weg der klassischen Datenbankanbieter.

Nachdem die Bibliotheken von den Softwareherstellern weitgehend im Stich gelassen wurden, haben sie eigene Aktivitäten entfaltet, um die immer dringlicher werdenden Integrationsleistungen für elektronisches Material aller Art, aber auch gedruckte Dokumente, zu verbessern. Es gibt viele Beispiele. Im Folgenden sollen nur einige wenige genannt werden. Zunächst bauten einzelne Bibliotheken „Digitale Bibliotheken“ auf, was auch immer jeweils darunter verstanden wird. Oft waren es anfangs nur systematisch geordnete Linksammlungen.

Seit Ende der 1990er Jahren wurde als Integrationsinstrument die Metasuchtechnologie eingesetzt. Der Karlsruher Verbundkatalog (KVK) wendete sie als erster für die gemeinsame Suche und Anzeige von Ergebnissen aus vielen Onlinekatalogen an. 2000 kam als Verbunddienstleistung die Digitale Bibliothek Nordrhein-Westfalen und führte auf diese Weise Recherche und Ergebnisanzeige für viele Fachdatenbanken, Kataloge sowie Bibliotheksdienstleistungen wie Dokumentlieferung und Fernleihe zusammen. Andere Verbünde und Kooperationen folgten. Erstaunlich ist die immer noch starke Präsenz der Metasuche. Sie ist für die Nutzung keine sehr komfortable Technologie und eigentlich mehr eine Notlösung. Denn die parallele Suche in vielen Datenbanken ist abhängig von den Antwortzeiten der jeweiligen Server, kann die Suche nur im Rahmen des gemeinsamen kleinsten Nenners durchführen und hat Probleme bei gemeinsamer Ergebnisanzeige, Ranking usw.. Dennoch hält sie sich hartnäckig.

Ebenfalls als Initiative der Bibliotheken, hier vor allem der Universitätsbibliothek Regensburg, wurde die Elektronische Zeitschriftenbibliothek gegründet (EZB). Sie ist die ZDB für elektronische Zeitschriften. Die deutschen Bibliotheken verfügen damit über ein hervorragendes gemeinsames Instrument für Nachweis-, und Zugangsverwaltung von elektronischen Zeitschriften. Der Versuch, in einem so genannten Dreiländerkatalog (DLK) die Katalogdaten aller Verbundsysteme in deutschsprachigen Ländern in einem gemeinsamen Suchmaschinenindex mit moderner Suchtechnologie anzubieten, ist beim HBZ allerdings wieder aufgegeben worden. Aber das Bibliotheksservicezentrum in Konstanz betreibt mit seinem BAM-System einen ähnlichen Ansatz weiter. Nicht nur Bibliotheksdaten, sondern auch Daten von Museen (z.B. der Stiftung Preußischer Kulturbesitz in Berlin), Archiven usw. werden zusammengeführt. Die UB Bielefeld entwickelte eine Art Wissenschaftsgoogle (Base) für Daten auf ausgewählten wissenschaftlichen OAI-Servern, die in einem Suchmaschinenindex zusammengeführt werden.

Auf eine Bibliotheksinitiative hin hat man in Dänemark bereits vor 15 Jahren begonnen, ein zentrales Speicher- und Suchsystem für große Mengen kommerzieller Daten (bibliographische und Volltextdaten) in einem Suchindex einzurichten, um sie dänischen wissenschaftlichen Einrichtungen über lokale Systeme zur Verfügung zu stellen. Damit wurde ein gemeinsamer schneller Zugang zu einer Vielzahl von Daten geschaffen. Das DTIC (Danish Technical Information Center) betreibt dieses Datenzentrum (DADS) mit der Suchmaschine ZEBRA. Es verfügt derzeit über fast100 Millionen Nachweise und Dokumente. In den letzten Jahren wurde dort in Zusammenarbeit mit der Königlichen Bibliothek und Primo von Ex Libris ein integriertes Frontend für Bibliotheks- und DADS-daten aufgebaut. Auch ausländische Dienstleister wie die ETH-Bibliothek in Zürich sind Kunden von DADS. Die Dänen verfolgen damit schon seit langem ein ähnliches Konzept wie die neu auf den Markt kommenden kommerziellen Systeme, aber auf einer Art konsortialer Basis.

Trotz dieser und vieler anderer Ansätze sind die Bibliotheken weit davon entfernt, in ihrem spezifischen Spektrum Google Paroli zu bieten. Die Welt googelt, auch die Welt der Wissenschaft. Alles ist aus einer Hand zugänglich. Was dort nicht gefunden wird, gibt es nicht. Qualität, Relevanz und Präzisionsrate treten dahinter zurück. Aber Qualität ist es, was Bibliotheken traditionell leisten wollen und sollen. Dabei haben sich die Bibliotheken trotz aller Unkenrufe zu Beginn des elektronischen Zeitalters ganz gut gehalten. In ihrem Marktsegment weisen sie beachtliche Zugriffszahlen auf.

2 Der Markt kommt in Bewegung. Neue Konzepte, cloud computing und die Firmen

Es besteht Einigkeit darin, dass in einer Art Google-Zugang im Onestop-Betrieb möglichst umfassend, aber auch präzise, die gesuchte wissenschaftliche Information gefunden werden soll. Natürlich ist der Idealfall nicht erreichbar. Aber auf der einen Seite sind die Grenzen der traditionellen lokalen Bibliothekssysteme ebenso erkennbar wie auf der anderen Seite die Notwendigkeit eines großen Schritts nach vorn hinein in diese Integration.

Und siehe da, nach langem Warten und Zögern, nach einer langen Zeit der kleinen Schritte, es bewegt sich etwas auf dem Markt. Von verschiedenen Seiten wird jetzt an großen Schritten gearbeitet und richtig Geld investiert.

Die erheblichen Investitionen der Softwarefirmen in das Electronic Resource Management (ERM) sind Vorläufer. Die Linkresolverdienste mit entsprechenden Knowledgedatenbanken gibt es schon länger, werden ständig verbessert und sind schon geeignetere Instrumente für die weitere Zukunft der Dokumentlieferung. In den letzten zwei Jahren arbeiten aber mehrere Firmen an einem neuen Konzept. Es handelt sich um den auch in Deutschland seit Jahren diskutierten umfassenden Suchraum. Dieses Konzept integriert die Arbeit, die bisher von verschiedenen Akteuren geleistet wurde. Es könnte einen ersten großen Durchbruch zum Onestopp-Service der Bibliotheken bringen und möglicherweise irgendwann auch Suchdienste wie Google für die wissenschaftliche Information ersetzen oder zumindest wirksam ergänzen. „Built from the ground-up and based on extensive end-user research, the service’s every element was designed to bring students and faculty back to the library as the starting point for research, rather than the Open Web” (Serials Solutions), dürfte das Ziel aller Anbieter sein. Wenn Technologie, Datenumsetzung, Frontend, Such- und Ergebnisqualität, Marktbedingungen und Preise stimmen, dürften daraus Erfolgsmodelle werden. Aber die vielen „Wenns“ zeigen auch die Risiken für einen Markterfolg. Dennoch gibt es Hoffnung.

Ex Libris war wohl der erste Hersteller, der diese Entwicklung vor 6 Jahren mit dem Aufbau von Primo als Discoverysystem begonnen hat. Andere Hersteller sind dem gefolgt. Die Discoverysysteme stellen Bibliotheken und Verbünden Software für den eigenen Einsatz zur Integration des Frontenddienstes für viele Arten von Daten zur Verfügung. Aber auch Ex Libris hat damals wohl kaum die heutige Entwicklung vorausgesehen. Die neuen Konzepte gehen weit über den Ansatz von Primo hinaus. Es geht jetzt nicht mehr einfach um Softwarelieferung, sondern um zentrale Dienstleistungen: Software as a Service (SaaS) – Dienstleistungen „alles aus einer Hand“.

Die formale Logik liegt auf Seiten dieses Ansatzes. Er trägt nämlich der Situation Rechnung, dass der größte Teil der lokal anzubietenden Daten gar nicht mehr lokal erstellt oder lokal vorgehalten, sondern aus Quellen unterschiedlichster Art im Internet abgeholt wird. Für lokale Systeme, selbst für eine große Universität, ist es weder wirtschaftlich noch wahrscheinlich überhaupt machbar, den Aufwand weltweiter Erschließung für den Eigenbedarf allein zu leisten. Ausgehend von dieser Einsicht sind auch in Deutschland schon viele Überlegungen angestellt worden, solche Dienstleistungen zusammen zu legen, wie die kooperativen Bemühungen der letzten 10 Jahre zeigen.

In Dänemark geht man diesen Weg nun konsequent weiter. Am 8.1.2010 ist die Frist für eine europäische Ausschreibung zum Aufbau eines neuen Systems abgelaufen. Ziel des Systems ist, eine National Data Well einzurichten. Diese National Data Well ist in ihrer Funktion auf ein Datensammelsystem in der Art eines Repository begrenzt, also ohne eigenes Suchsystem. Dort sollen alle nationalen und internationalen Daten, die von dänischen wissenschaftlichen Einrichtungen genutzt werden, zentral vorgehalten und aktualisiert werden. Die Daten werden dann über deren eigene Suchsysteme und Frontends den Nutzern zur Verfügung gestellt. Die Ausschreibung hat 4 Angebote erhalten: DTIC zusammen mit EXL, TDNet, die Staatsbibliothek Aarhus zusammen Serials Solutions und Serials Solutions allein. Der zentrale neue nationale Datenhost mit Schnittstellen zu anderen Systemen in Dänemark eröffnet dann Möglichkeiten für weitere Entwicklungen und Umstrukturierungen, auch im Bibliotheksbereich. Die Zusammensetzung der Anbieter zeigt, dass von Anfang an eine Zusammenarbeit mit der Industrie stattfinden wird. Zwei der drei beteiligten Firmen sind zudem auch Anbieter der neuen Discoverydienste.

Das jetzt von mehreren Firmen angegangene SaaS-Modell geht wesentlich weiter als das dänische in seiner gegenwärtigen Ausprägung. Bibliographische und Volltextdaten freier und kommerzieller Provenienz aus dem Internet, sowie die Daten der Kunden wie Bibliotheken, Universitäten usw. werden mit aufwändigen Technologien in einem zentral gehosteten Suchsystem (cloud computing) zusammengeführt. Wenn das lokale Bibliothekssystem aufgegeben wird, geht auch die Verwaltung der lokalen Daten komplett an das SaaS-System über. Die Daten der Welt werden ebenso gesammelt, erschlossen, nutzbar gemacht wie die lokalen Daten und stehen (soweit nötig mit Lizenzverträgen) allen Kunden gemeinsam zur Verfügung.

Cloud computing liegt im allgemeinen Trend. Die Verteilung von zentraler und dezentraler Intelligenz verläuft in Wellenlinien und ist vom jeweiligen Stand der technischen Entwicklung abhängig. Die IT Branche richtet sich jetzt wieder mehr auf zentrales Hosting ein, das in „clouds“ stattfindet. Darin werden Steigerung von Effektivität und Servicequalität unter gleichzeitiger Kostensenkung erwartet. Insofern entsprechen die SaaS-Modelle der allgemeinen Entwicklung.

Es handelt sich um vier Firmen, die aus unterschiedlichen Teilen der Branche kommen. Zwei Firmen, nämlich Serials Solutions, das zu Proquest gehört, und EBSCO stammen aus der Sparte der Datenproduzenten/Datenbankanbieter/Datenaggregatoren. Dabei ist EBSCO Datenproduzent und Datenbankanbieter, Serials Solutions über die Mutter Proquest Datenbankanbieter. Serials Solutions ist über seine 360 series auch lokaler Dienstleister für ERM (inklusive link resolver usw.), aber die Dienste werden nur zentral gehostet angeboten. OCLC hat noch nie ein vollständiges lokales System als ILS hergestellt (mit Ausnahme der in Europa zugekauften PICA- und SISIS-Systeme), war aber von Anfang an ein weltweit wichtiger Akteur für lokale Bibliotheksdienstleistungen. Ex Libris ist der einzige Hersteller traditioneller Bibliothekssoftware, der sich an dem Rennen beteiligt. Ex Libris und EBSCO haben am 9.7.2009 eine Zusammenarbeit angekündigt. Über den Stand der Zusammenarbeit war nichts zu erfahren. Nach der Produktkonzeption beider Firmen werden sie wohl auf dem Markt als normale Konkurrenten auftreten. Das bisher unterschiedliche Aktivitätsspektrum der vier Firmen dürfte sich auf die Gestaltung der Schwerpunkte ihrer neuen Produktserien auswirken.

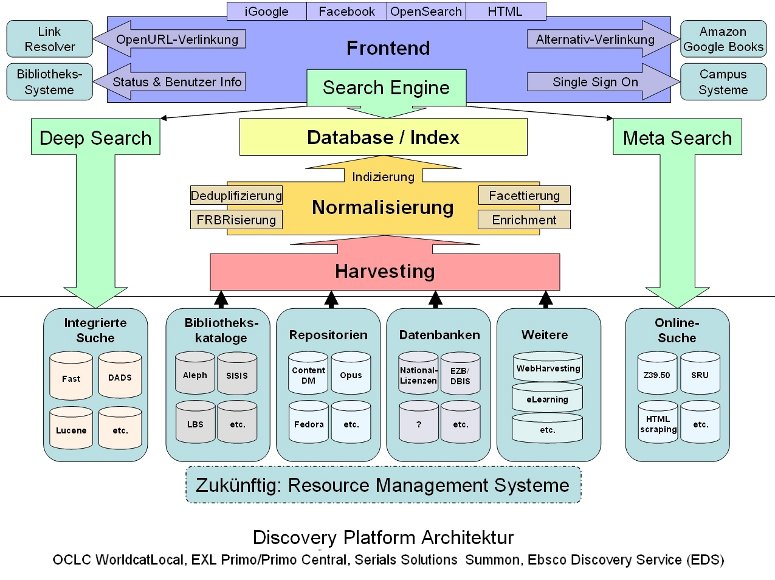

Alle Systeme bieten eine gewisse Flexibilität bei der lokalen Ausgestaltung von Benutzeroberfläche und Design. Als Suchsystem hinter dem Frontend steht Suchmaschinentechnologie. Alle Daten, die dafür geeignet und nutzbar sind, werden in den Suchindex eingeführt. Darunter kommt dann die Normalisierung zur Zusammenführung unterschiedlicher Daten zum Einsatz. Bibliothekskataloge, Repositorien, alle Arten von Datenbanken, Knowledgebases, Daten aus dem Webharvesting usw. werden über Harvester der Normalisierung zugeführt und wandern dann in den Suchmaschinenindex. Damit stehen für alle Daten die Vorzüge von Datenaufbereitung, Suche und Navigation durch Suchmaschinen zur Verfügung: gemeinsames Ranking, Volltextsuche, Facets, Drilldown, aber auch Deduplifizierung, FRBRisierung, Enrichment usw. Die Metasuche wird ergänzend für externe Ressourcen eingesetzt, die anderweitig nicht zugänglich sind. Alle Anbieter sehen einen online Zugang zu den ILS verschiedener Hersteller vor.

Die Abbildung zeigt eine grobe schematische Darstellung der neuen Suchraumhierarchie. Sie bildet sicher keines der Produkte exakt ab, zeigt aber die Grundfunktionen und die Datenströme. So dürfte z. B. die OCLC-Lösung über WorldCat zwar anders ablaufen, aber im Prinzip ähnliche Funktionen enthalten, Deep Search dürfte eine Eigenheit von Ex Libris sein usw.

3 Chancen, Probleme und Fragen

„Alle Daten aus einer Hand“ heißt alle Daten in einem Index. Das klingt zunächst gut. Dadurch entstehen aber riesige Datenbanken. Die schiere Größe allein wird dennoch nicht entscheiden. Einmal kommt es auf Qualität und Auswahlkriterien der Daten an. Zum anderen wird es ein Google ähnliches Problem mit den Ergebnismengen geben. Wie gut handhabbar und präzise werden Suche, Navigation und Ranking sein? Wie komfortabel die Ergebnisweiterverarbeitung?

Das altbekannte Problem zwischen „normaler“ und Expertensuche bleibt. Die Masse der Benutzer braucht vermutlich nicht mehr als ein möglichst einfach zu bedienendes allgemeines Suchsystem. Die Experten benötigen aber ihre fachspezifische Suche über entsprechende Indices und Thesauri, um präziser und zuverlässiger Ergebnisse zu erzielen. In wie weit beide Anforderungen über ein gemeinsames System abgebildet werden können, hängt von der Flexibilität von Suchsystem und Art von Suchdaten ab. Werden die Bibliotheken, je nach zu bedienender Klientel, in bestimmten Fällen Fachdatenbanken parallel zum allgemeinen Suchmaschinenindex vorhalten müssen?

Laut Discoveryanbieter sehen ihre Verträge mit den Herstellern kommerzieller Daten vor, dass die vorhandenen Lizenzverträge zwischen Kunden und Herstellern einfach weiter genutzt werden. Für den Hersteller ist dies dann nur ein weiterer Vertriebskanal der Lizenznutzung. Zusätzliche Kosten entstehen nur für die Dienstleistungen des Discoveryanbieters. Diese sind normalerweise nach bestimmten Gesichtspunkten pauschaliert und beziehen sich nicht unbedingt auf das angebotene Datenvolumen und die Zahl der kommerziellen Datenbanken. Die Preismodelle sind vermutlich noch nicht voll ausgereift. Dafür sind die Produkte zu neu. Aber einige Hersteller kündigen Preismodelle nach FTEs an. Die Aufbereitung der lokalen Daten gehört zum Preismodell. Grundsätzlich sind die Discoveryanbieter auch bereit, weitere Daten und Datenbanken auf Kundenwunsch ohne Zusatzkosten in ihren Index aufzunehmen. Dies dürfte allerdings nur für Daten gelten, die von allgemeinem Interesse sind. Für die Aufnahme sehr spezifischer Daten werden vermutlich Zusatzkosten entstehen.

Die Firmen betreiben derzeit geradezu einen Wettlauf im Kampf um die meisten und schönsten Daten. Alle wollen möglichst alles in ihrem zentralen Suchindex haben und möglichst wenig Metasuche. Nicht alle Datenhersteller sind aber bereit, ihre Daten anderen Anbietern zur Verfügung zu stellen. Allerdings ist sehr wohl ein vorsichtiges Umdenken bei kommerziellen Datenherstellern und Verlegern zu beobachten. Elsevier z. B. hat sich lange auf eigene Vertriebskanäle wie Scopus konzentriert, beginnt sich jetzt aber anderen Anbietern zu öffnen. Andere große Datenanbieter wie ISI haben dies schon längst getan. Dennoch halten etliche wichtige Datenbanken mit einem gewissen Alleinstellungsmerkmal an ihrem Angebotsmonopol fest.

Deshalb schafft niemand, alle Datenbanken in dem allgemeinen Index anzubieten. Dafür gibt es dann die gute alte Metasuche. Alle Discoveryanbieter investieren in Verbesserung und Optimierung der Metasuche, um sie komfortabler zu machen und die großen Nachteile zur Suchmaschinensuche zumindest zu minimieren. EBSCO kündigt seine neue Metasuche geradezu enthusiastisch an, „taking federated searching to a new level“. Auch andere Firmen wie Ex Libris sind von der Leistung ihrer „Next Generation Metasearch“ sehr überzeugt. Man darf gespannt sein. Schließlich setzt auch die Digibib NRW immer noch weitgehend auf die Metasuche. Übergangslösungen halten sich sehr lange.

Die Marktakzeptanz hängt sicher auch von den Möglichkeiten der lokalen Ausprägung ab, dem „branding“ und dem Umgang mit lokalen Daten. Jede Bibliothek möchte „ihre“ Dienste für ihre Community anbieten, ihre Identität wahren und deshalb über großen Freiraum für die Präsentation des Angebots verfügen. Schließlich umfasst das Frontend die gesamte Wahrnehmung des Benutzers. Ein wesentliches Qualitätsmerkmal werden aber auch Flexibilität und Leistungsfähigkeit bei Aufbereitung, Normalisierung und Präsentation lokaler Daten bilden. Hinzu kommt die Fähigkeit, sich auf lokale Dienstleistungswünsche einzustellen. Die Systemanbieter tragen dem Rechnung, aber sicher in unterschiedlicher Weise mit unterschiedlichen Gestaltungsmöglichkeiten.

Die üblichen social services bzw. der Zugang dazu sind heute Standard. Aber auch die Einbeziehung anderer lokaler Dienste z. B. E-learning dürfte über geeignete Schnittstellen und Webservices kein Problem sein.

Bleibt die Frage: wo ist die cloud? Alle vier Firmen bieten ihre Dienste von den USA aus an. Alle Daten wandern also auf US-Computer. Es hat in der Reagan-Zeit bereits Tendenzen gegeben – veranlasst durch den Kalten Krieg – Europäer von der Versorgung mit US-Daten abzuschneiden. Die Beendigung des Kalten Krieges hat diese Diskussion beendet. Aber wer weiß, wie es auf längere Sicht weiter geht? Anbieter werden, wenn der Markt sich entwickelt, clouds auch in anderen Teilen der Welt positionieren müssen. Ex Libris und OCLC denken durchaus schon über eine cloud Verteilung in der Welt nach. Es wird auch Knoten in der cloud geben, z. B. Verbundsysteme.

Außerdem wird die Bereitschaft, z.B. der Hochschulen, einen großen Teil ihres wissenschaftlichen Informationsangebots für Hochschulangehörige ganz aus der Hand zu geben, unterschiedlich sein. Wer weiß, ob und wann die Kunden nahtlos auf SaaS übergehen? Da liegen auch Risiken für die Anbieter, die traditionelle lokale Systeme bedienen. Insofern sehen die Firmen unterschiedliche Stufen der Teilnahme vor. Alle bieten deshalb online- Schnittstellen zu den ILS der bekannten Hersteller.

Natürlich könnte man solche SaaS-Dienste in unterschiedlichen Kombinationen auch national oder regional betreiben. Das dänische Beispiel zeigt die Richtung, die auch in anderen Ländern begehbar wäre. Es wären auch nationale und internationale kooperative Lösungen in Europa denkbar. Selbst in Deutschland wäre der Aufbau eines entsprechenden kooperativen SaaS-Dienstleisters vorstellbar, auch unter Beteiligung oder unter Federführung der Verbundsysteme. Das dänische Konzept sieht von Anfang an eine Zusammenarbeit von staatlichen Einrichtungen mit der Industrie vor. Zwei staatliche Einrichtungen als Teilnehmer am Wettbewerb bieten mit Partnern aus der Industrie. Schade, dass so etwas in Deutschland mit den Verbundsystemen gegenwärtig wohl nicht möglich ist.

Das Ziel der Anbieter ist natürlich, den Markt auf ihre Webscalesysteme mit cloud computing umzusetzen. Discovery ist der Einstieg. Diese Systeme sind z. T. bereits auf dem Markt oder kurz vor ihrer Markteinführung. Beginnend in ungefähr 2 Jahren sollen dann die nunmehr Resource Management Systeme genannten neuen Bibliothekssysteme folgen. Alles aus einer Hand meint auch alles. Dann wird im Idealfall das lokale System vollständig ersetzt. Alle Daten und Funktionen wandern in das zentrale System zum „cloud computing“.

Selbst bis zum Masseneinsatz der SaaS-Discoverysysteme ist noch ein weiter Weg. Aber Firmen wie das OCLC bereiten den amerikanischen Markt schon massiv auf cloud computing vor: „The collective vision is ... to move services to the network or ‚cloud‘„. „We want to manage information, not hardware“ wird der Dean einer amerikanischen Universitätsbibliothek zitiert. Sehen wir, was die Zukunft bringen wird. In den USA wird der Übergang wohl in den nächsten zwei bis drei Jahren ziemlich nachdrücklich einsetzen, in Europa deutlich später und vermutlich mit vielen abgestuften Lösungen.

Spannend wird auch die Frage, wie es dann mit den derzeitigen „Digitalen Bibliotheken“ wie der Digibib, Vascoda und den vielen anderen in Deutschland, aber auch mit den ILS von OCLC in Europa weitergeht. Aber bis dahin ist ja noch viel Zeit. Vielleicht auch Zeit, darüber nachzudenken.

4 Kurze Übersicht über Hersteller und Produkte (lt. Herstellerangaben)

Serials Solutions

Das Produkt heißt Summon und ist als SaaS-Lösung das erste auf dem Markt. Man konzentriert sich darauf, möglichst alle Daten in die Summon-Datenbank zu bekommen. Der ISSN-Abgleich mit Linkresolvern großer Bibliotheken hat eine Datenübereinstimmung von 97% und mehr ergeben. Summon bedient auch Konsortien. Die Konsortien sorgen für Lizenzen, Resolver usw.. Der Service kommt von Summon. Der Preis für wissenschaftliche Bibliotheken berechnet sich nach FTEs.

Serials Solutions hat durch die Anbindung an Proquest große Erfahrung mit dem Aufbau differenzierter Suchsysteme und dem Handling großer Datenmengen. Es unterhält für ihre 360 Dienste eine große Knowledge Datenbank (KnowledgeWorks Database) für Daten aus elektronischen serials, E-Books und anderen elektronischen Dokumenten. Die zentrale Summondatenbank umfasst derzeit rund 500 Millionen Datensätze mit Inhalten von 6200 Verlegern, davon 2/3 Zeitungsartikel, 100 Millionen Artikel aus 94.000 Zeitschriften und Magazinen (großenteils mit Volltextsuche), 400 Datenbanken, Dissertationen, MARC records, lokale Daten usw.. In Zukunft sollen auch Daten in OAI-Servern geharvested werden. Als Suchmaschine wird SolrAjax (open source Produkt) verwendet. Summon selbst sieht keine Metasuche vor. Diese steht aber über die 360 Dienste zur Verfügung. Für die Normalisierung der Daten wurde eine Datenbank mit 20 000 Regeln eingerichtet. Serials Solutions ist auf dem deutschen Markt noch kaum vertreten und hat nur einige Kunden für die 360-Dienste. Summon wird seit Mitte 2009 vermarktet und verfügt gegenwärtig über mehr als 50 Kunden, überwiegend in Nordamerika.

Zum Verbund von Serials Solutions gehört auch Aquabrowser. Aquabrowser wird von Medialab in Holland betreut. Es ist vielleicht das älteste Discoveryprodukt für den OPAC. In Europa wird es von Bowker und in den USA von Serials Solutions vertrieben. Es verfügt ebenfalls über eine eigene große Datenbank und nutzt Daten von lokalen Systemen unterschiedlicher Hersteller (Ex Libris, III und anderen). Aquabrowser wird üblicherweise als lokale Installation betrieben. Serials Solutions will in den USA die zentral gehostete Lösung favorisieren.

Einsatzbeispiele für Summon unter: http://dartmouth.summon.serialssolutions.com und http://adelaide.summon.serialssolutions.com/ Ferner als neuere Nachricht: http://distlib.blogs.com/distlib/2010/01/thoughts-from-the-summon-advisory-board-meeting.html

OCLC

Die zentrale Datenbasis für alle Dienstleistungen ist der seit vielen Jahren aufgebaute WorldCat. Worldcat wird in großen Schritten ständig erweitert. Ab Januar 2010 z. B. kommen die derzeit 23 Millionen records von OAIster der Universität von Michigan in den WorldCat-Index hinzu. OAIster ist eine Art unioncatalogue, der durch laufendes Harvesting von rund 1100 OAI-Sammlungen in der Welt aktualisiert wird.

Das Produkt heißt WorldCat Local. Das eigentliche Produktziel aber sind die Web-scale Management Services (WSMS). Diese gibt es noch nicht, aber erste Schritte in diese Richtung. Der erste Schritt ist der so genannte Quickstart. Der WorldCat erhält dabei lediglich einen Abzug der lokalen Daten, um sie im WorldCat suchen zu können. Der nächste Schritt ist WorldCat Local. Dort wird über ein WorldCat UI der Zugang zum lokalen Bibliothekssystem eröffnet. Damit werden WorldCat und lokale Systeme verbunden. Das entspricht dem Discoverysystem. Das UI soll alle gängigen lokalen Systeme, ebenso wie geläufige kommerzielle Linkresolver abdecken. Die Preise für wissenschaftliche Bibliotheken werden nach FTE und für öffentliche nach Bevölkerungszahl berechnet. Es werden aber zwei Lizenzen, nämlich für WorldCat und WorldCat Local benötigt. Auch OCLC bietet eine neue Metasuche an, die dann im Preis enthalten ist. Für Deutschland wird parallel zu WorldCat Local als Discovery-Lösung TouchPoint angeboten. Die deutsche Homepage von OCLC jedenfalls nennt WorldCat Local in der Produktliste gar nicht. Das liegt u. a. daran, dass WorldCat Local gegenwärtig keine Schnittstellen zu LBS und Sunrise hat. TouchPoint ist die Discoverysoftware für den lokalen Einsatz und das Konkurrenzprodukt für Primo. Die lokale Flexibilität von WorldCat Local ist sehr begrenzt. Das Produkt ist in Deutschland vorwiegend für Öffentliche Bibliotheken gedacht. TouchPoint nutzt als Suchmaschinen Lucene und Fast und kann in beiden ebenso suchen wie im WorldCat. WorldCat Local wird gerade in England mit einem OLIB-System erprobt und soll im Sommer 2010 auf den deutschen Markt kommen. Der letzte Schritt in der US-Systematik sind dann die vollen Web-scale Management Services unter Einbeziehung der lokalen Funktionen. Sie sollen ab 2011 einsatzfähig sein. Erste Teile davon werden als Piloten erprobt. Derzeit testet ein Kranz von Pilotbibliotheken in Nordamerika Ausleihe und Benutzerverwaltung. ERM wird folgen.

OCLC wirbt in Nordamerika bereits seit längerem für die volle SaaS-Lösung, obwohl das Web-scale-System noch längst nicht fertig ist. Es wird an die „resource sharing“-Tradition der Bibliotheken appelliert: „... libraries use the same shared hardware, services and data rather than hosting hardware and software on behalf of individual libraries. The cooperative nature of this project leverages the powerful ethos of library resource sharing – opening up opportunities for cooperative intelligence by making sharable data available to all users”. In Kürze soll ein „global advisory council” die Entwicklung für den Bedarf außerhalb Nordamerikas begleiten.

Auf oclc.org sind die den jeweiligen Regionen angepassten (also auch für USA und Deutschland) offiziellen Darstellungen nachzusehen. Touchpoint ist für Schweizerische Bibliotheken als Discoverysoftware im Einsatz: swissbib.ch

Ex Libris

Das Produkt heißt Primo Central. Ex Libris hat mit Primo vermutlich als erster die Discoverysoftware bereits 2007 auf den Markt gebracht und arbeitet seit 2009 an der Realisierung des SaaS-Konzepts. Das Primo Frontend bleibt als Frontend-Software ein gesondertes Produkt. Primo Central ist als zentraler Megaindex der Kern des Discoverysystems. Ein Frontend wird zusätzlich benötigt. Das kann Primo, aber auch das Produkt eines anderen Herstellers sein. Primo und Primo Central haben softwaretechnisch die gleiche Architektur. Primo ist die lokale Discovery und Delivery Plattform. Sie bereitet die bibliotheksspezifischen Datenquellen auf. Primo durchsucht auch per Deep Search (wahrscheinlich ein feature, das nur von Ex Libris verwendet wird) den Datenbestand von Primo Central und mischt dann die Ergebnisse beider Systeme (lokal und Central). Die lokalen Daten werden beim Ranking gesondert berücksichtigt, damit sie nicht in den Primo Central Ergebnissen untergehen. Ex Libris hebt besonders seine Normalisierungs- und Anreicherungsleistungen mit Hilfe seiner Publishing Plattform (wichtig gerade auch bei Übernahme unterschiedlicher lokaler Daten), die flexiblen Möglichkeiten in der Zusammenarbeit mit lokalen Systemen sowie die individuelle Behandlung lokaler Daten (Auswahl, Filterung usw.) hervor. Als Hersteller lokaler Bibliothekssoftware muss Ex Libris schon aus eigenem Interesse eine besonders abgestimmte und sanfte Migrationsstrategie auf die neuen Systeme betreiben. Als Suchmaschine wird Lucene verwendet. Das cloud computing wird auf Servern von Amazon in den USA durchgeführt. Auch Ex Libris entwickelt mit dem Produkt Unified Resource Management (URM) eine Ablösungsstrategie für die lokalen Systeme, die aber wohl frühestens 2012/13 marktreif sein wird.

Ex Libris baut mit großem Aufwand die große zentrale Datenbank seit 2009 auf, hat dabei aber von seiner Herkunft her als Softwarehersteller gegenüber den drei anderen Akteuren sicher einen größeren Aufholbedarf. Dennoch enthält die Datenbank bereits 120 Mio. Datensätze von 8200 Verlegern, Artikel aus 52000 Zeitschriften (z. T. mit Abstracts, Volltextindexierung usw.)

Die Firma teilt in einer Pressemitteilung vom 14.1.2010 mit, dass nunmehr der Betatest von Primo Central mit 14 Partnern beginnt. Im deutschsprachigen Gebiet versorgt Ex Libris vier Verbundsysteme und viele lokale Systeme mit Software. Primo wurde neuerdings von mehreren Hochschulbibliotheken in Deutschland und der Schweiz gekauft. Dazu gehört vorerst eine kostenlose Testzeit von Primo Central. Für Primo im Einsatz gibt es Beispiele, für Primo Central noch keine öffentlich zugänglichen Testsites, daher nur: http://www.exlibrisgroup.com/category/PrimoOverview

EBSCO

Das Produkt heißt EBSCO Discovery Service (EDS). EBSCO bezieht sich sehr stark auf das Leistungsspektrum seiner traditionellen EBSCOhost services, das über 300 online-Datenbanken betreibt. Entsprechend kann die Suche in EDS und Host verbunden werden. Dadurch kann EBSCO die vielen in den Host-Datenbanken genutzten spezifischen Schlagwort Indexe als Suchbegriffe auch in EDS verwenden. Auf diese Weise könnte allgemeine und Spezialistensuche gemeinsam abgedeckt sein. EDS erhebt auch den Anspruch, mehr „fulltext for searching“, mehr subject heading-Erschließung einzusetzen und über mehr Primärverleger als Partner zu verfügen als irgend ein Wettbewerber. Beim Ranking haben subject headings Vorrang. EBSCO hebt besonders auf Auswahl, Aufbereitung und Suchqualität seiner angebotenen Daten ab und erhebt weiter den Anspruch, einen wesentlich besseren Content als z. B. Summon zu haben: „with seven times as many third party content partners ... as any other discovery service“, „the most comprehensive online research service in the industry“ und „a preindexed service of unprecedented size and speed“. Ob das auch für die gepriesene Metasuche, die EBSCOhost@Integrated Search (EHIT), gilt? Aber immerhin gibt es dafür über 3000 Konnektoren. Für die „customization to a new level“ des „local branding“ wurde ein eigener EBSCOhost@Integration Toolkit (EIT) entwickelt.

EBSCO gibt keine Daten über Volumina der EDS Datenbank heraus. Die Mitbewerber „build virtually the same index for every customer. Ours is truly customized for each library” mit naturgemäß sehr verschiedenen Volumina abhängig von deren Bestand. Damit verbunden ist in der Regel eine größere Erschließungsbreite und -tiefe.

EDS steht kurz vor der Markteinführung. EBSCO hat als Datenbankanbieter viele Kunden in Deutschland und von daher eine gute Ausgangsposition.

Öffentliche zugängliche EBSCO Darstellung von EDS: http://www.ebscohost.com/discovery/

Autor

Dr. Karl Wilhelm Neubauer

Ltd. Bibliotheksdirektor i.R.

Hauptstraße 7

38388 Twieflingen

kwneubauer@yahoo.de

![]()

INHALT

INHALT INHALT

INHALT