WEITERE NEWS

WEITERE NEWS

- Sense about Science and Taylor & Francis launch research integrity toolkit for early career researchers

- Gemeinsam Zukunft unternehmen: Deloitte-Stiftung zeichnet fünf Bildungsinitiativen mit dem Hidden Movers Award aus

- Open Access: Zwei weitere Schriftenreihen des Sorbischen Instituts (sorabistische Forschungseinrichtung) frei zugänglich

- Studie: Non-formale Bildungsangebote fördern nachhaltige Entwicklung, geraten jedoch zunehmend unter Druck

- Verstärkung für Inlibra – David Simons wird Key Account Manager

- Maria Aurora von Königsmarck: die „berühmteste Frau zweier Jahrhunderte“ – Hybridedition

- WissKom Award 2025 für das Forschungsprojekt #LastSeen

- Einstein Foundation Award 2025: Die Gewinner:innen des mit 350.000 Euro dotierten Preises stehen fest

Aktuelles aus

L

ibrary

Essentials

In der Ausgabe

- Gen Z und Gen Alpha: Wie junge Zielgruppen Medien zwischen TikTok und Haltung neu definieren

- Ethische Verantwortung im Umgang mit biomedizinischen Archiven

- Open-Research-Plattformen im Praxistest

- Digitale Technologien im Kulturerbe: Forschungsentwicklung zwischen Datenanalyse und KI-Unterstützung

- KI-Texte beliebter als Originale

- Zines als Impuls für soziale Gerechtigkeit in Bibliotheken

- Ein dezentrales Fundament für Open Science: Warum Forschungsdaten neue Infrastrukturen brauchen

- Vergessenes Wissen auf Disketten: Cambridge rettet digitale Geschichte

- Europas Bibliotheken im Visier von Kunstraub

- Nach dem Aus von Baker & Taylor: US-Bibliotheken suchen neue Buchgroßhändler

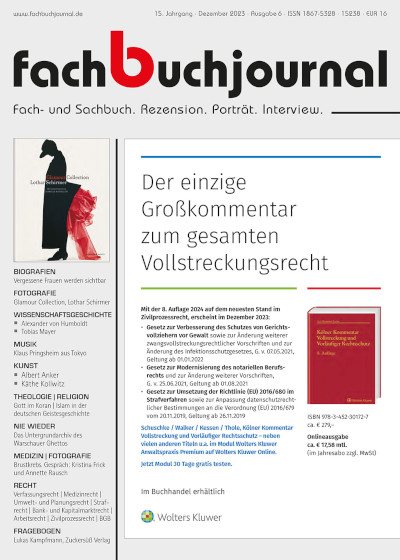

fachbuchjournal